Bien utiliser les différents termes de l'Intelligence Artificielle

Il faut qu’on vous avoue quelque chose…C’est très difficile à exprimer, alors nous irons droit au but ! L’Intelligence Artificielle ne sert pas à travailler, ni à prendre des décisions à votre place !

Pourquoi ? Parce que c’est tout simplement irréalisable pour l’instant. Les recherches autour des Intelligences Artificielles avancent d’année en année. Nous découvrons des programmes très impressionnants tels que ChatGPT, Lensa ou Dall•E, qui annoncent, pour le futur, de nouvelles opportunités de support au travail des Humains. Mais ce n’est pas une raison pour dire n’importe quoi sur les IA, et ce pour plusieurs raisons :

– Pour ne pas se fier à 100% aux contenus des IA, sans vérification ;

– Pour ne pas décevoir les utilisateurs ;

– Pour ne pas décevoir des investisseurs potentiels ;

– Pour ne pas limiter les IA à un sujet informatique ;

– Pour recruter des personnes qualifiées etc.

Vous l’aurez compris, plus vous utiliserez correctement les termes et le vocabulaire de l’Intelligence Artificielle, plus vous serez à même de ne pas vous faire avoir, ou de générer trop d’attente autour d’un projet d’IA.

On vous explique ?

#1 — Il n’y a pas une, mais DES Intelligences Artificielles

Au sens stricte, l’Intelligence Artificielle est un ensemble de théories, techniques et disciplines, dont l’objectif est de doter la machine d’une simulation d’intelligence humaine, sur plusieurs périmètres :

- L’apprentissage ;

- La communication ;

- L'aide à la décision ;

- La résolution de problème ;

- La création ;

- La fabrication ;

- La prédiction...

- Ressentir

- Construire une opinion

- Exprimer des émotions

- S’adapter

- Tirer des leçons personnelles…

Au même titre qu’il n’y a pas un seul modèle d’intelligence chez l’Humain, il y a plusieurs modèles d’Intelligence Artificielle :

L’IA faible ou étroite – ANI

- Il s’agit des IA mises en œuvre aujourd’hui sur différents services : chatbot, moteur de recherche, outil de ciblage, reconnaissance faciale, reconnaissance vocale.

- Elles sont dites « faibles » car elles sont configurées en amont pour imiter une action unique, de manière automatique, à partir de bases de connaissance définies et encadrées.

- Elles ne sont pas pleinement autonomes, et nécessitent des vérifications.

L’IA forte ou générale – AGI

- Ce type d’IA n’est aujourd’hui qu’au stade du concept et de l’expérimentation.

- Pour passer d’une IA faible à une IA forte, il faudrait qu’elle soit en mesure de s’adapter à l’imprévu, apprendre d’elle-même, raisonner et comprendre « exactement » comme un humain, pour résoudre des problèmes, et réagir à des situations.

La super intelligence – ASI

- C’est l’IA de science-fiction, à savoir une IA qui agirait exactement comme l’Humain

- C’est l’IA qui aurait son individualité, et sa conscience propre, quitte à surpasser l’Humain, grâce à des capacités d’analyse et de ressenti qui lui seraient propre

Où est-ce qu’on veut en venir ?

- Il faut être vigilant dans la manière de présenter un projet d’IA, afin de ne pas décevoir l’utilisateur…ou des financeurs, avec une solution miracle

- On ne peut pas réduire l’IA à une discipline purement informatique et technique

- L’activité d’une IA doit toujours être supervisé et vérifié

Exemple d’abus

de langage

- Sens n°1 / Catégorie Abus Gentil : Notre entreprise investit dans l’automatisation pour faciliter certaines tâches

- Sens n°2 / Catégorie Abus Abusé : Notre entreprise n’investit dans rien du tout, mais parler d’IA c’est bon pour l’image

- Sens n°1 / Catégorie Abus Gentil : Notre CRM segmente bien vos fichiers clients, suggère des actions, automatise les envois d’e-mail

- Sens n°2 / Catégorie Abus Abusé : Les commerciaux ne connaissent pas bien le produit, mais maîtrisent les mots à la mode

- Sens n°1 / Catégorie Abus Gentil : Notre solution facilite la prise de décision, en organisant bien les données

- Sens n°2 / Catégorie Abus Abusé : Nous utilisons des anglicismes à la mode, pour vendre une solution qui fait de jolis tableaux de bords

#2 – Les notions à ne pas confondre

IA et Machine Learning

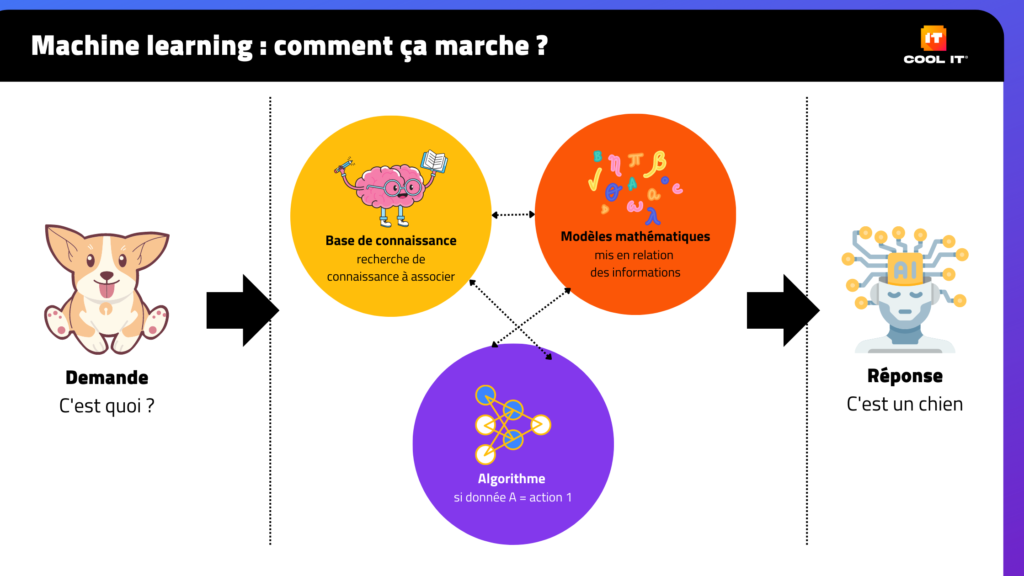

Le Machine Learning est un modèle d’apprentissage pour les IA. À partir d’un ensemble de données, d’algorithmes et de modèles mathématiques, le Machine Learning permet à un système informatique de réaliser des actions, sans être directement dirigé par l’Humain.

Le Machine Learning est exploité dans plusieurs champs d’application comme la reconnaissance vocale (Siri, Alexa), la vision par ordinateur (analyse d’images), la prédiction de résultats, la compréhension de langage naturel (chatbot), reconnaissance d’image (recherche inversée), le transport autonome, la recommandation, le ciblage publicitaire…

IA et Deep Learning

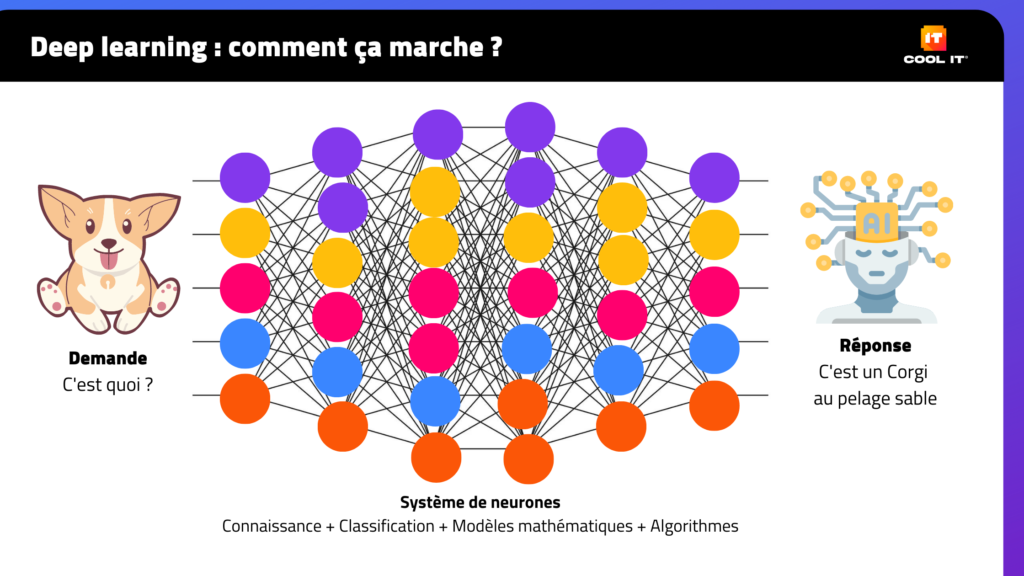

Le Deep Learning est un autre modèle d’apprentissage pour les IA. Ce modèle vise à intégrer des réseaux de neurones dits « profonds » pour permettre aux IA d’analyser des données, de manière plus subtile.

Contrairement au Machine Learning qui traite la donnée de manière linéaire, le Deep Learning apprend aux IA à traiter les données par couche, de plus évident au plus abstrait, comme un arbre de décision géant. On l’exploite aujourd’hui pour la reconnaissance d’image, la reconnaissance vocale, la compréhension de langage naturel, la génération de contenu, la traduction, la détection de fraude…

IA et Algorithme

En informatique, un algorithme est une suite d’étape que l’on rédige, qu’on modélise, à partir de différentes informations, pour qu’un système informatique génère des résultats ou des actions.

Les algorithmes ne sont pas des IA, mais une partie de ce qui les fait fonctionner.

IA et Automatisation

L’automatisation n’est pas qu’un procédé informatique, on peut automatiser des choses de manière mécanique, en faisant appel à l’électronique, sans utiliser de systèmes informatiques.

- En informatique, l’automatisation consiste à utiliser des algorithmes pour effectuer des tâches sans l’intervention directe de l’Humain. Exemple : l’envoi d’e-mail programmé

- Il n’y a pas systématiquement une IA derrière un système automatisé.

IA et Chatbot

Un chatbot est un programme informatique capable de converser avec l’Humain, en langage plus ou moins naturel. Pour ce type de service aussi, il n’y a pas systématiquement une IA derrière.

- Les chatbots, sans IA, fonctionnent plutôt comme une F.A.Q dynamique, avec des questions et des réponses pré-enregistrées, à partir de mots-clés.

- Les chatbots, qui intègrent une IA, analyse le langage, apprennent au fur et mesure des échanges, et sont en capacité d’affiner leur réponse.

- Les faux chatbots vous font échanger avec des Humains. Ceux sont des chats quoi !

Les mondes imaginaires sont-ils toujours des safe place pour les personnes minorisées ?

Pendant longtemps, les jeux vidéo qui se déroulaient dans des mondes imaginaires, pouvaient être un moyen d’affirmation de soi pour les personnes minorisées. Ou un moyen de s’évader d’un système oppressif.

L’avatar, notamment, pouvait être, aussi bien une réplique de soi-même, qu’une projection de ce que la société nous empêche d’être. Le choix d’un rôle, du contrôle d’une histoire, pouvait être un moyen de ré-appropriation de ce qui nous échappe IRL[1].

Pourtant, 83%[2] des gamers, de 18-45 ans, ont subi du harcèlement en jouant aux jeux vidéo, dont 71% allant jusqu’à des agressions graves : menaces physiques, stalking[3], chantage…Ces agissement sont en augmentation depuis 2019.

Pour 1 gamer sur 2, les raisons sont liées à leur religion, leurs identités de genre, leur orientation sexuelle ou leurs origines. Même dans un monde imaginaire, iels se retrouvent alors, autant stigmatisé·e·s que dans leur quotidien « réel ».

[1] IRL = In Real Life, Dans la vraie vie

[2] Rapport de l’ONG ADL “Hate is No Game: Harassment and Positive Social Experiences in Online Games 2021”

[3] Stalking = Fait de traquer une personne en ligne et/ou dans la vraie vie

#1 C’est quoi une safe place ?

C’est un espace bienveillant et protecteur, où des personnes minorisées et discriminées, se retrouvent pour différentes activités, très souvent empêchées ou polluées par des personnes oppressives.

Ces espaces sont aussi bien physiques que virtuels. Ils sont souvent fondés, par et pour les personnes minorisées, avec ou sans leurs allié•e•s

Dans les milieux du jeu, les safe place sont surtout créés pour jouer en ligne loin des « haters » » et des » trolls », mais aussi pour donner de la visibilité à des profils de joueur•ses qu’on ne voit pas assez.

On les retrouve notamment dans des associations militantes, des groupes de discussion ou des applications de mise en relation.

#2 C’est quoi un HATER et un TROLL ?

Hater

[ɛ.tœʁ] Nom, anglicisme

Personne qui dénigre d’autres personnes sur internet, en raison d’un critère qu’iel déteste, un désaccord, ou un biais d’intolérance

Troll

[tʀ ɔl] Nom, originaire de Suède

Personne ou message, qui vise à provoquer et/ou susciter des polémiques afin de perturber une discussion ou une personne

#4 Comment en sommes-nous arrivés là ?

Dans les faits, le harcèlement et agressions en ligne, ont toujours été présents dans les communautés de jeux en ligne. On peut pointer plusieurs phénomènes qui ont contribué à renforcer ces comportements :

- L’augmentation de la pratique du jeu multi-joueur en ligne, associé à des canaux de discussion, où les joueurses discutent pendant le jeu (chat, live streaming, salon audio…)

- L’évolution des moyens de cyberharcèlement et cyberintimidation intraçable. Les agresseurs redoublent d’ingéniosité pour contrecarrer les règles de modération

- Il est de plus en plus facile de « stalker » une personne afin de récolter des informations pour lui nuire. On appelle ça le « doxxing »

- Les agressions se déroulent en majorité dans le jeu, et laisse de moins en moins de traces à l’écrit

- L’écran donne l’impression aux agresseurs, que leurs actions n’ont pas de conséquences

- Ce sentiment d’impunité est d’autant plus renforcé par le manque de volonté de modération et/ou de moyen de modération, sur les plateformes de discussion

#5 Les mondes imaginaires restent des créations humaines, avec des biais bien humains

L’un des éléments qui « permettent » (avec de GROS guillemets) aussi les agressions, c’est la narration des jeu, associée aux représentations qu’évoquent certains personnages.

Même si les mondes sont imaginaires, ils peuvent parfois répliquer :

- Des rapports de dominants-dominés ;

- Des rapports abusifs ;

- Des situations qu’il faut résoudre par la violence ;

- De la fétichisation et/ou sexualisation des corps.

On va éviter les raccourcis type « Les jeux vidéo rendent violents ». L’idée ici est de rappeler qu’en fonction de nos biais, et de nos vécus, certaines représentations, certaines histoires, entretiennent la violence des agresseurs, et leur sentiment d’impunité.

Nous faisons plutôt face à une double problématique, liée à des sujets plus sociétaux :

- Le manque de sensibilisation contre le harcèlement et ses conséquences

- Le manque de sanction et de médiatisation des sanctions face à ces comportements

#6 Le soucis de la performance

Autre motif, qui poussent certaines personnes à polluer l’expérience de jeu, c’est leur rapport à la performance de jeu.

Pour les jeux narratifs, l’objectif est d’entretenir une histoire

Pour ces types de jeu-là, on peut davantage jouer en ligne, dans un cadre bienveillant, car on n’a peu, voire pas, d’interaction avec d’autres personnes.

Pour les jeux de gestion ou de création, l’objectif est de créer puis de gérer un monde

En fonction des joueur•ses, les premières agressions viennent parce qu’on n’est pas d’accord sur la manière de faire ; pour saboter les choix du groupe ; ou venir d’une frustration de ne pas être en mesure d’avoir un monde aussi « stylé » que les autres.

Pour les jeux d’affrontement, l’objectif est d’être le n°1

C’est là qu’on retrouve le plus de « toxicité » liée à la performance

- On reproche aux autres sa défaite, ou celle de son équipe

- Pour les plus intolérants, on estime qu’il n’y a que les hommes cisgenres, qui soient capables d’être performants

- Pour les plus frustrés, on y estime que les personnes marginalisées qui performent, prennent la place des joueurs « qui étaient là avant »

- Pour les plus incohérents, on décrète que les personnes marginalisées perturbent la performance…par leur existence

#7 Les safe place, on les crée

Malheureusement et heureusement, les safe place sont des espaces qui se créent par les personnes concernées.

Ce qui est cool

- On peut y être soi-même

- Il y a moins de toxicité

- Il y a davantage de soutien et d’entraide

- L’expérience de jeu est peu perturbée

- La modération est réelle et plus efficace

Ce qui est moins cool

- Le problème des haters et des mauvais trolls n’est toujours pas résolu

- Les plateformes ne sont pas assez responsabilisées sur les sujets de modération, ni de sensibilisation

- Pour les débutant•e•s, les espaces bienveillants ne sont pas accessibles tout de suite

- Ce sont les victimes qui ont la charge de se protéger

Cybersécurité : à quoi sert un exercice de crise ?

Quand on pense à exercice de crise, comme beaucoup de sujet de cybersécurité, on a tendance à se dire qu’on n’est pas concerné, que c’est un projet lourd à mettre en place, ou qu’on se posera la question le jour où cela arrivera.

Nous savons aussi que l’approche par le risque est une approche lourde pour bon nombre d’organisation, parce qu’elle peut être rapidement anxiogène.

Et pourtant ! Rien de mieux que la mise en situation pour comprendre les enjeux de sécurité ! Et ce, pour plusieurs raisons :

- Cela permet de se poser les bonnes questions ;

- Cela implique toute l’entreprise ;

- Cela permet de visualiser concrètement ce qu’on fait de bien et ce qu’on peut améliorer.

On va vous éviter les expressions bateaux, type « il vaut mieux prévenir que guérir », mais globalement, en sécurité informatique, les coûts du manque d’anticipation ou de sensibilisation peuvent être très importants pour votre entreprise, quelle que soit sa taille.

Alors, dans quel contexte faut-il organiser un exercice de crise ? Sous quelle forme ? Avec qui ? Erwan Moyon vous fait part de son retour expérience, en tant qu’Ingénieur SI, anciennement Consultant en Sécurité des Systèmes d’information.

#1 — Qu’est-ce qu’un exercice de crise en cybersécurité ?

Un exercice de crise est une mise en scène, comme un jeu qui intègre différents acteurs d'une entreprise. Il se veut ludique et accessible.

Son objectif est de tester des situations de crise propre à l’entreprise pour mettre en avant des points d’amélioration, de sensibiliser et former les équipes à ce type d’évènements rares.

Dans le cadre de la cybersécurité, il s’agit d’organiser une mise en situation de cyberattaque ou de cyberincident.

#2 — Dans quel cadre doit-on organiser un exercice de crise ?

Il y a différentes situations qui peuvent justifier l’intérêt d’organiser des exercices de crises :

- Lorsque l’entreprise devient publiquement connue, cela attire les hackers et personnes malveillantes ;

- Lorsque l’entreprise a été hackée et a besoin de s’entraîner dans sa gestion de crise ;

- Lorsque l’entreprise s’apprête à lever beaucoup d’argents, ou dans le cadre d’une fusion-acquisition qui viendrait à modifier l’organisation de l’entreprise

#3 — Est-ce qu’il faut obligatoirement des spécialistes de la cybersécurité pour le faire ?

Les spécialistes sont les garants du suivi et de l’application des procédures de réponses à une crise. Ce n’est pas obligatoire, mais cela reste préférable pour :

- Conseiller la direction ;

- Définir des scénarii basés sur les tendances des cyberattaquants ;

- Investiguer et analyser les incidents qu’on va mettre en scène ;

- Accompagner les équipes IT et métier pour faciliter la communication et la remontée d’information ;

- Analyser les résultats de l’exercice et définir les plans d’amélioration et de sensibilisation

#4 — Quel type d’exercice de crise peut-on organiser ?

Il existe deux types d’exercice de crise : L’exercice sur table et l’exercice en réel.

Leur mise en place diffère en fonction des moyens de l’entreprise et de ses objectifs.

L’exercice sur table consiste à définir un scénario de crise propre à l’entreprise et de suivre une chronologie d’évènements. Ces évènements sont définis sur papier (ou PowerPoint).

Tous les participant•e•s vont devoir répondre à chaque évènement comme s’il était réel.

L’avantage de ce type d’exercice est qu’il est rapide à mettre en place et à simuler car il ne nécessite pas d’utiliser le système d’information.

L’exercice en réel est une mise en situation réelle. Par exemple, on peut installer un vrai sur une copie du système d’information. On va ensuite analyser en temps réel l’évolution du virus, ses impacts, les moyens à déployer pour le mitiger, la réaction des équipes etc.

L’avantage de ce type d’exercice est qu’il permet de tester le fonctionnement des logiciels de sécurité et d’analyser l’organisation de l’entreprise face à une cyberattaque.

En revanche, il nécessite un temps de préparation conséquent.

#5 — C’est quoi le déroulé classique d’un exercice de crise ?

Un exercice de crise s’organise en plusieurs temps.

Il faut d’abord cadrer et définir des scénarii de crise : que souhaite-t-on évaluer ? Quel est l’objectif de l’exercice de crise ? De quel type d’intervenants a-t-on besoin ? Quels sont les moyens IT qu’on peut mobiliser ? Qui est disponible pour y participer ? En moyenne, il faut bien 1 à 2 mois de préparation

Ensuite, il faut mobiliser les équipes, sur des temps où elles sont réellement disponibles. Il ne faut pas oublier qu’un exercice, c’est comme un jeu de rôle ou une simulation, il faut vraiment être impliqué dedans pour cela fonctionne. Si les équipes ont d’autres priorités ou si elles sont prises de court, l’exercice va les contraindre plus que les sensibiliser.

Pour les mobiliser, il est essentiel de prendre le temps d’expliquer régulièrement l’objectif de l’exercice, mais surtout de présenter les bénéfices que cela peut avoir. Pour cela, il faut aussi prévoir un plan de communication interne, au moins 1 mois à l’avance, avec des rappels. Quitte à mettre en place une permanence, pour répondre aux questions des participants.

L’exercice en lui-même dure de 1 à 3 jours, en fonction des scénarii choisis.

À la fin de l’exercice, on réalise un bilan à chaud, comme à la fin d’une formation. On organise également une enquête quelques temps après l’exercice. Cette enquête permet de comprendre comment l’exercice a été vécu, évaluer le niveau de compréhension, évaluer la culture sécu de l’entreprise en cas de crise…

Enfin, on réalise également un bilan global, à froid, qui comprend les points d’amélioration, mais aussi les bonnes pratiques à maintenir. Ce bilan est censé être décliné en plan d’action.

#6 — Comment faut-il communiquer un exercice de crise ?

La communication est très importante lors de l’organisation d’un exercice de crise

Les personnes mobilisées ne sont pas nécessairement très sensibilisées à ce qu’est un exercice de crise, notamment sur des sujets informatiques. Elles connaissent les risques de leur activité, mais n’y pensent pas tous les jours.

Il faut favoriser une communication en plusieurs temps également, avant, pendant et après. On peut évoquer les enjeux de l’exercice, réfléchir à des messages ludiques, d’autant plus qu’un exercice est assez ludique !

#7 — Qu’est-ce qu’on fait après avoir mis en place l’exercice ?

Après avoir réalisé un exercice il faut :

- Tirer un bilan des points positifs (ce qui a fonctionné) et les points d’amélioration (ce qui a moins bien fonctionné)

- Maintenir une certaine transparence sur les bilans, en évitant d’enjoliver les points d’amélioration ; le but de l’exercice c’est d’apprendre de nos erreurs courantes

- Définir un plan d’action cyber : mise à jour de procédures, renforcement de la communication, amélioration des outils…

- Le must du must, c’est de prévoir d’autres exercices pour s’améliorer continuellement jusqu’à qu’il y ait une vraie culture de la cybersécurité dans l’entreprise

#8 — C’est quoi les bénéfices concrets d’un exercice de crise ?

Concernant la cybersécurité, c’est une opportunité pour l’entreprise de :

- Identifier les points d’amélioration

- Comprendre les problèmes de communication interne et de sensibilisation à la sécurité

- Mettre en place des bonnes pratiques de cybersécurité, en fonction de chaque activité, de chaque outil utilisé

- Sensibiliser l’entreprise à la gestion de crise et instaurer une culture sécurité

Comment mettre en place une feuille de route pour un projet informatique ?

« Alors on en est où ? »

Cette question anodine suscite à la fois de l’enthousiasme (quand on a bien avancé) mais aussi beaucoup de frustration (quand on est en retard ou qu’on ne sait pas).

Pour arriver à y répondre sans stress, il y a un outil imparable, à la fois collaboratif et structurant : le feuille de route (ou roadmap).

Quelle que soit la forme que vous lui donnez, la feuille de route permet à tous les intervenant•es d’un projet informatique :

- Identifier les rôles et les relations entre chaque personne

- Comprendre les objectifs du projet

- Suivre les avancées et les communiquer

- Prioriser et réagir en cas de retard

C’est l’outil qu’il vous faut ? On vous explique en quelques étapes comment définir votre feuille de route IT.

#1 — C’est quoi une feuille de route concrètement ?

Une feuille de route, également appelée roadmap, est un document qui présente les principales étapes à suivre pour réaliser un projet. Ces étapes ont pour vocation d’être ensuite planifiées dans le temps.

Pour un projet informatique, à quelques spécificités près, le découpage est assez standard :

- Analyse de l’existant

- Conception

- Développement

- Test

- Déploiement

- Maintenance

#2 — Comment structurer une feuille de route ?

Une feuille de route se structure en trois grandes parties :

- Tout d’abords, vous définissez des « jalons », c’est-à-dire un ensemble de temps forts et/ou d’objectifs à atteindre

- Dans ces jalons, vous spécifiez des tâches à réaliser pour atteindre chaque objectif. En fonction des jalons, il y a peut-être un ensemble de tâches à rassembler en « chantier », qui constituent un « sous-jalon »

- Pour chaque tâche ou chantier, vous associez des personnes qui auront chacune des responsabilités dans la réalisation des tâches

- Ceci fait, vous inscrivez un niveau de priorité et des échéances pour chaque tâche ou chantier

- À l’issue de ce découpage, vous avez suffisamment d’éléments pour faire un planning

#3 — Quels sont les contenus les plus importants à suivre dans une feuille de route ?

Pour que votre feuille de route soit efficace, il y a plusieurs éléments importants à intégrer, et à valider régulièrement :

| À intégrer | À valider |

| Les charges temps | Combien de temps faut-il pour réaliser une tâche ? Ce temps a-t-il été respecté ? |

| Le budget | Combien a-t-on investi pour aboutir un jalon ?Combien a-t-on réellement dépensé ? |

| Les rôles et responsabilités | Les rôles sont-ils cohérents ? Les niveaux de responsabilité sont-ils clairs ? Les effectifs sont-ils suffisants ? |

C’est uniquement sur la base de ces éléments, qu’il est possible de définir une feuille de route claire, et suffisamment précise pour piloter un projet.

#4 — Comment mettre à jour une feuille de route ?

Nous mettons une feuille de route à jour dans les situations suivantes :

- Quand un chantier, une tâche ou un jalon est terminé

- Quand un risque vient impacter ou remettre en question la réalisation d’un chantier ou d’une tâche

- Quand une tâche a été mal estimée, ou qu’une nouvelle tâche doit être ajoutée et planifiée

#5 — Qui doit avoir la charge du suivi d’une feuille de route ?

Une feuille de route est gérée et pilotée par un•e chef•fe de projet, qui la met à jour en collaborant avec les différents intervenant•es du projet :

- Les équipes métiers ;

- Les services IT ;

- Les intervenant•es externes.

#6 — Quels sont les supports les plus pertinents pour mettre en forme une feuille de route ?

Il n’existe pas de supports prédominants pour définir une feuille de route, cela dépend des affinités du/de la responsable du projet, avec les outils qu’il/elle utilise habituellement.

En revanche, on peut identifier des usages spécifiques en fonction du support :

- Les outils de bureautique (type Suite Office) :

- EXCEL : Utiliser pour définir le planning et organiser les chantiers du projet

- PowerPoint : Utiliser pour communiquer les avancées et réaliser le reporting lié à la feuille de route

- Sharepoint : Utiliser pour communiquer les avancées de manière plus ludique et visuelle, pour associer des documents

- Les outils de gestion de backlog type JIRA ou Trello : Outil tout-en-un, très orienté développement informatique, pour planifier et définir les chantiers d’un projet en même temps

- Les outils de planning type Planner ou Monday : Outil collaboratif, plutôt orienté processus, qui permet à la fois de planifier et de donner une vue d’ensemble au projet

Une fois structurée, les rôles clarifiés et les différentes charges du projet définies, le suivi d’une feuille de route offre plusieurs bénéfices :

- Fluidifier la communication : Une feuille de route est facile à lire ce qui permet de rapidement communiquer sur ses avancées, blocages, etc. auprès de n’importe quel interlocuteur d’un projet

- Renforcer la collaboration : Ce document unique et central permet de renforcer les échanges et le travail entre les équipes IT et les équipes métiers

- Faciliter la prise de décision : Une feuille de route permet de rapidement mettre en avant des risques capacitaires, financiers ou les conflits de planning, afin de prendre des décisions

- Prioriser les chantiers : Une feuille de route permet rapidement d’identifier et de définir des priorités vis-à-vis des jalons importants, de leur complexité de réalisation et des délais de livraison

Prêt à mettre en pratique nos conseils ?

Voici un outil signé Cool Kit pour vous exercer à définir votre feuille de route informatique

➡️ https://coolkit.coolitagency.fr/toolspage/details/14 ⬅️

Pourquoi mettre en place une politique de gestion de mots de passe ?

“123456”, “qwerty”, “password”, “marseille”, “loulou”… En 2021, les pires mots passe sont toujours les mêmes. On estime même que 406 millions mots de passe ont été divulgués en 2021, soit une moyenne de 6 mots de passe par habitant (source NordPass).

En moyenne, il faut moins d’une seconde pour hacker un compte personnel, qui utilise un mot de passe trop simple. Pour une entreprise dont la gestion des mots de passe est faiblement sécurisée, le risque est le même.

Dans cet article, nous allons vous donner quelques pratiques fondamentales pour mettre en place une politique de gestion de mots de passe.

#1 — Définir un mot de passe complexe

Tout commence avec le bon choix du mot du passe ! Choisir un mot de passe sécurisé permet de :

- Réduire les risques qu’une personne malveillante accède à un compte utilisateur de l’entreprise ;

- Renforcer la sécurité des comptes administrateurs ;

- Intégrer la sécurité dans les bonnes pratiques professionnelles des collaborateurs.

Il y a plusieurs critères à intégrer dans son mot de passe, afin de garantir un niveau de sécurité suffisant :

- 12 caractères minimum ;

- Au moins 1 majuscule ;

- Au moins 1 minuscule ;

- 1 chiffre et un caractère spécial.

On vous l’accorde, il est difficile de retenir et d’innover constamment ce type de mot de passe. Pour cela, le plus simple reste d’utiliser un générateur de mot de passe, comme le générateur en ligne motdepasse.xyz ou les générateurs de logiciel de sécurité en ligne tels que Dashlane, 1password ou Avast.

#2 — Éviter la réutilisation de mot de passe

Même si le mot de passe est complexe, s’il vient à être compromis et divulgué sur internet, il devient inutilisable.

Les hackers utilisent des programmes pour automatiser leurs attaques et trouver les mots de passe.

Dès qu’ils ont en trouvé un, ils le réutilisent sur d’autres sites internet, et ainsi de suite. Les mots de passe volés sont soit revendus, soit utilisé pour compromettre les données de l’entreprise.

Il faut donc éviter au maximum la réutilisation de mots de passe, même avec quelques variantes, comme : « loulou22 », « loulou23 » … Les hackers anticipent également les variations possibles.

#3 — Utiliser un coffre-fort numérique

Avec la multiplication des outils en ligne, nous avons forcément une multiplication de mots de passe. Cette multiplication de mots de passe peut parfois mener à des failles dans la politique de mot de passe, ou l’utilisation de mémo matériel, très risqué : tableau Excel, post-it…

L’utilisation d’un coffre-fort numérique peut permettre de :

- Stocker l’ensemble des mots de passe sur un serveur sécurisé ;

- Générer aléatoirement des mots de passe complexes ;

- Se connecter sans avoir à saisir les identifiants et mots de passe ;

- Partager des données sensibles de manières sécurisées.

Le coffre-fort est protégé par un seul mot de passe maître à retenir. La perte ou la compromission de cet unique mot de passe peut être prise en charge par l’éditeur qui vous propose le coffre-fort.

Parmi les plus connus du marché, on retrouve : Dashlane, NordPass, KeePass, LastPass...

#5 – Éviter de passer par des systèmes tiers, non-dédiés à la sécurité

Google, Facebook, Twitter, LinkedIn… proposent tous des moyens de s’authentifier via leur propre système d’authentification. Le problème avec des services tiers, c’est la dépendance. Si ces derniers viennent à être attaqués, il y a un risque à ce que les accès de l’entreprise soient compromis.

Il en va de même pour les navigateurs : Chrome, Firefox, Edge etc. Ces services sont régulièrement attaqués, et comportent régulièrement des failles de sécurité.

Pour les sujets de sécurité, comme les mots de passe, il vaut mieux privilégier des services dédiés à la sécurité (générateurs, coffre-fort…)

#5 – Activer la double authentification

On ne le répète jamais assez ! Le risque zéro n’existe pas ! On œuvre surtout à réduire les risques au maximum. Les pratiques citées ci-dessus permettent de réduire les risques de vol de mot de passe, mais ne l’empêche pas 100%

Pour renforcer la sécurité d’accès à un compte, il est également conseillé d’en renforcer l’accès via la double authentification.

Cette méthode de sécurité permet, au moment de la connexion à son compte, d’utiliser un second moyen d’authentification pour accéder à son compte. On vérifie doublement la personne qui devra se connecter via un SMS, un e-mail, une application en plus.

Les bénéfices de la double authentification sont multiples :

- Renforcer la sécurité des accès aux comptes sensibles de l’entreprise ;

- Empêcher l’accès à un compte même si le mot de passe a été volé ;

- Renforcer la sécurité en dehors du bureau.

Les méthodes de cyber hacking de mots de passe continuent de se perfectionner, au fil des années. Les attaques sont de plus en plus subtiles. Par exemple, on sait qu’aujourd’hui les hackers peuvent tenter de contrepasser la double authentification.

Pour réduire les risques de sécurité, les entreprises doivent impérativement s’armer d’une politique de gestion de mots passe robustes :

- Définir des mots de passes complexe ;

- Privilégier les coffres forts numériques ;

- Éviter les solutions tierces ;

- Sensibiliser les collaborateurs à la réutilisation ;

- Mettre en place la double authentification.

En complément de ces pratiques, on peut ajouter le renouvellement des mots de passe tous les 90 jours, afin de toujours garder un temps d’avance sur les attaques possibles. Sans oublier, de sensibiliser régulièrement les collaborateurs sur les différents risques et actualités cyber liés aux mots de passe.

Comment sécuriser son entreprise avec des logiciels Open Source ?

Chaque année, 370.000 logiciels Open Source sont téléchargés dans le monde. Le dernier rapport de Sonatype, appelé « State of the Software Supply Chain 2020 » a même identifié que 29% de ces logiciels possédaient des vulnérabilités, soit un tiers du marché actuel de l’Open Source. En 2021, le nombre d’attaques utilisant des vulnérabilités Open Source a augmenté de 650%

La plus importante et dernière en date concerne l’exploitation d’une vulnérabilité appelée Log4Shell. Cette vulnérabilité a été détectée dans le logiciel Log4Js, lui-même utilisé par le logiciel Apache, solution utilisée par des dizaines de milliers de site web.

Cet évènement a remis au centre des préoccupations les conditions d’utilisation des logiciels Open Source, les pratiques de maintenance et de financement.

#1 — Open Source, de quoi parle-t-on ?

Un logiciel Open Source, ou logiciel libre, est un programme informatique dont le code est publiquement accessible. N’importe qui peut y accéder, le modifier et en distribuer le code. L’Open Source existe depuis que l’informatique existe.

Le modèle de développement d’un logiciel Open Source est différent d’un logiciel propriétaire :

- Il se repose sur le travail bénévole de communautés de développpeur·ses, à maintenir le code du logiciel sans demander de contrepartie financière

- Il s’enrichit de manière collaborative, n’importe qui, tant qu’iel en a les compétences peut contribuer à améliorer le code

- Il est censé entièrement responsabiliser les utilisateur·rices, qui peuvent eux-mêmes l’exploiter comme iels le souhaitent

La fiabilité d’un logiciel Open Source est donc fortement associée aux développeur·ses qui le maintiennent. Les solutions les plus fiables, comme celles de Red Hat (1er éditeur mondial de solutions Open Source), sont gratuits pour les utilisateur·rices les plus débrouillard·es, payants pour celles et ceux qui souhaitent bénéficier d’un service similaire à une version propriétaire.

En dehors de ce modèle, la gratuité totale peut amener à des problématiques de mise à jour, sécurité, de performance, d’ergonomie…

#2 — Que renforce les dernières cyber actus des problématiques du Logiciel Libre ?

Depuis Log4Shell, on réalise que les risques cyber, qui ciblent les failles de l'Open Source, peuvent être subtiles mais ne sont pas inédites. Tels que l’exploitation de codes vulnérables, le sabotage de logiciels, le découragement des développeur·ses…

Les raisons sont diverses :

- Peu ou pas d’audit interne en amont ;

- Peu ou pas de vérification de la qualité du code ;

- Surcharge de travail des développeur·ses Open Source ;

- Maintenance peu réalisée après la mise en production …

90% des programmes informatiques existants utiliseraient des modules Open Source pour fonctionner. Cela sous-entend que la majorité des programmes du marché sont dépendants de leur fiabilité.

Du fait de cette dépendance, il y a un réel enjeu à valoriser l'Open Source d’une part, et d’autre part à renforcer les politiques de maintenance.

3 — Pourquoi financer les développements Open Source ?

Le développement Open Source n’est pas gratuit pour ses créateur·rices. Il demande du temps, souvent pris sur le temps libre de développeur·ses passionné·es. Pour en tirer profit, il est primordial de valoriser les communautés qui font vivre ce milieu, afin qu’iels aient les moyens de proposer des solutions plus fiables.

Les modèles de rémunération peuvent être divers :

- Recruter un·e développeur·se et/ou un expert en interne pour travailler sur la maintenance ;

- Rémunérer directement les développeur·ses Open Source, si iels proposent des services de maintenance ;

- Financer des programmes Open Source : collectifs, formation, entreprise spécialisée, initiatives gouvernementales...

Néanmoins, il faut garder en tête que l’Open Source ne fonctionne pas pour tout. Cela requiert un véritable questionnement sur la dépendance informatique et sur sa propre politique de maintenance, de sécurité.

4 — Mais du coup, doit-on arrêter d'exploiter les logiciels Open Source ?

Non ! L’Open Source contribue à l’enrichissement de l’informatique.

Il permet :

- d’accélérer l’innovation

- de maintenir l’accessibilité logiciel aux organisations plus modestes

- d’expérimenter des produits

Ce n’est pas le modèle d’organisation qui est à revoir, mais l’exploitation des logiciels.

Pour citer Sylvain Abélard, ingénieur logiciel chez Faveod : « Le soucis n’est pas les gratuit, c’est de mal exploiter le gratuit. »

Pour une meilleure exploitation des logiciels libres, il faut donc :

- Être en mesure de se responsabiliser, calibrer leur dépendance et investir davantage sur la maintenance, la sécurité

- Soit fournir des contreparties justes aux acteur·rices de l’Open Source

Ainsi, les organisations pourraient être en mesure d’entretenir un cercle vertueux. La traçabilité des développements contribueraient à la fois au maintien des valeurs de l’Open Source, mais aussi au maintien des organisations de ses exploitants.

Flex office : les étapes à ne pas manquer côté informatique

Le Flex Office consiste à proposer un espace de travail où les bureaux ne sont pas attitrés.

Renforcé par l'évolution du travail hybride, le Flex office permet à l’entreprise de réduire ses coûts immobiliers, tout en proposant aux salarié-e-s des conditions de travail, elles aussi flexibles.

Il permet également de répondre à un besoin croissant des salarié-e-s de pouvoir travailler dans des conditions différentes, selon son organisation et ses tâches quotidiennes, elle dynamise également les échanges entre collègues.

D’un point de vue informatique, un plan d’action est nécessaire pour détailler l’ensemble des tâches attendues pour assurer une mise en place efficace, et faciliter au maximum l’accès aux outils de travail.

Ces différentes actions impliquent différents acteurs IT :

- Un-e chef de projet IT en charge de la coordination du projet, du planning, de l’analyse des coûts d’investissement et de l’organisation du déploiement

- Un-e responsable IT en charge de réaliser les inventaires logiciels et matériels

- Un-e responsable de la conduite du changement en charge à la fois de la communication avec les salariés et managers, de l’identification des points de blocages et de réticences, et de l’accompagnement au changement des services métiers et IT

- Un-e responsable des services généraux pour l’organisation de l’espace de travail

Le service IT est garant de la réalisation et de l’accompagnement des équipes dans la mise en place du flex office.

Les services métiers seront, quant à eux, régulièrement consultés durant la réalisation de ces actions.

#1 — Réaliser un inventaire du matériel informatique

La première étape à suivre, avant de lancer la mise en place du flex office, consiste à réaliser un inventaire du matériel informatique de l’entreprise et d’identifier le nombre de :

- Ordinateurs fixes et portables

- Appareils téléphoniques (smartphones et téléphones fixes)

- Bornes WIFI

- Decks et câbles de chargement d’ordinateurs

- Écrans d’ordinateurs

Il faut ensuite valider la mise à disposition pour chaque salarié-e d’un moyen de rangement sécurisé de leurs affaires. Les postes n’étant plus attribués, les salarié-e-s ont besoin de déposer leurs matériels et effets personnels dans un endroit qui leur est propre. Il faut prévoir pour chacun un casier sécurisé et de quoi transporter son matériel facilement.

#2 — Référencer les logiciels informatiques

Les logiciels informatique et systèmes de stockages de fichiers sont à inventorier pour identifier les manques et assurer la continuité d'activité des salarié-e-s.

Pour cela, il faut :

- Lister les solutions informatiques utilisées

- Identifier pour chaque logiciel, s’il est accessible à distance via une connexion internet

- Prévoir de faire évoluer ou de changer les logiciels qui ne permettent pas de travailler à distance

- Stocker les données sur un disque dur et/ou serveur externe géré par un infogérant, ou sur une solution cloud telles que Google Cloud Storage, OneDrive, Dropbox, IBM Cloud Storage…

#3 – Organiser l’espace de travail

Pour organiser l’espace, il faut dans un premier temps valider le nombre de postes « flex office » qui sera mis à disposition.

A l’issu de cette identification, il faut :

- Quantifier le nombre d’écrans par poste

- S’assurer de la mise à disposition d’un moyen de chargement de l’ordinateur

- Vérifier la qualité du réseau WIFI

L’espace de travail en mode flex office doit comprendre des espaces de réunion et des salles d’appel Même en flex office, les équipes maintiennent le besoin d’avoir des temps collectifs en réunion et des temps d’appel en espace individuel.

Il est également conseillé de prévoir un système de visioconférence performant pour le travail hybride (CISCO, Teams, OneDirect, Zoom…) qui permette aux salariés de maintenir la cohésion d’équipe, même dispersée. Attention cependant à l’effet réunionite ! Les visio doivent être plus brèves et plus cadrées pour rester pertinentes pour les salarié-e-s présents et à distance.

#4 – Identifier le coût d’investissement à réaliser

A l’issue de l’analyse et de la réalisation des précédents points, il est possible d’identifier le coût d’investissement pour la mise en place du flex office.

D’un point de vue matériel et réseau :

- Identifier les écrans et autres matériels manquants à acheter ou à remplacer

- Identifier les besoins d’investissement dans des solutions réseaux (bornes WIFI, changement d’opérateurs, renforcement de la fibre…)

Si l’entreprise utilise des téléphones fixes, le salarié-e doit pouvoir maintenir sa propre ligne privée. Pour cela il existe deux types de solutions :

- Passer sur des solutions de téléphonie VoIP (via TrunkSIP ou autres solutions)

- Passer sur des solutions de téléphonie SaaS qui redirigent les appels vers le poste utilisateur

Attention cependant, à bien encadrer et respecter les temps de disponibilités de chacun.

En cas d’usage d’ordinateurs fixes, il faudra soit envisager d’investir dans des solutions de virtualisation de postes de travail (VMware, Compufirst, Windows Virtual Desktop…) ou de remplacer le matériel par un ordinateur portable.

Concernant les logiciels, le changement de logiciels implique de :

- Valider les logiciels devant être remplacés

- Réaliser un benchmark pour valider les nouveaux logiciels

- Potentiellement investir dans une prestation de service, si l’équipe IT est surchargée ou en sous-effectif

- Décommissionner les anciens logiciels (arrêt et finalisation des contrats)

#5 – Déployer le Flex Office

A partir du moment où les inventaires sont réalisés, le coût d’investissement défini et que le mode d’organisation des équipes est identifié, la mise en place technique du flex office peut débuter.

Pour cela, il faut :

- Procéder à l’achat du matériel manquant

- Installer les nouveaux logiciels et migrer les systèmes informatiques

- Renforcer la communication auprès des équipes avec le partage d’un retroplanning, une communication et des échanges réguliers

- Organiser une semaine de tests sur les postes dédiés

- Prévoir un jour de télétravail le jour de la bascule

#6 – Accompagner au changement

L’accompagnement au changement débute dès le début de la mise en place du flex office, à savoir :

- Préparer une communication sur ce qu’est le flex office, ses impacts, avantages et ce que cela implique en termes de changement ;

- Identifier avec chaque manager l’impact organisationnel que cela va avoir ;

- Identifier les irritants et les contraintes ;

- Renforcer la communication interne de manière positive : apports dans les relations professionnelles, retours d’expériences, étude de situation… ;

- Planifier des temps d’échanges pour évaluer le bon déroulé du flex office : points d’attention, axes d’amélioration, état du matériel, état de la cohésion d’équipe…

Quel que soit la taille de l’entreprise, le flex office est un mode d’organisation qui nécessite un plan d’action concret, qui implique :

- Un inventaire du matériel ;

- Un référentiel des logiciels ;

- Une évolution des méthodes de management ;

- Des investissements immédiats ;

- Un plan de conduite du changement ;

- Une politique d’amélioration continue des conditions de travail.

Le retour sur investissement peut être rapide et permet à l’entreprise de revoir ses méthodes de management. Elle permet également à l’entreprise d’accélérer sa transformation digitale, de gagner en agilité dans la gestion de son Système d’Information.

Cela permet de mélanger des corps de métier qui discutent peu en temps normal.

Pour les équipes IT, c’est l’opportunité de valoriser davantage le rôle que les équipes jouent dans l’organisation du travail et ses mutations.

Besoin de renfort pour mettre en place du Flex office ?

Vous pouvez écrire à Erwan, l'auteur de l'article

Besoin d'un modèle plus visuel pour organiser votre mode Flex office ?

Découvrez notre modèle Trello

Pourquoi faut-il faire attention à la surestimation de son potentiel numérique ?

La surestimation du potentiel numérique est un phénomène courant, qui peut survenir à la mise en place d’un nouveau projet informatique.

Cette surestimation se décline en trois principes :

- La surestimation des effectifs ;

- La surestimation des compétences ;

- La surestimation de l’environnement technique.

Attention ! Nous ne parlons pas ici de « surestimation » au sens, « votre organisation est plus mauvaise que vous le pensez », pas du tout. L’idée de cet article est de vous sensibiliser à l’importance d’évaluer correctement les manques et les prérequis de votre organisation, avant de mettre en place un nouveau projet informatique.

On ne le dit jamais assez. Un nouveau logiciel, appli, système, ne solutionne pas les problèmes de fond, il les exacerbe ! C’est pour cela qu’il est important de prendre du recul à chaque nouveau projet et d’y intégrer toutes les personnes concernées.

Alors, comment savoir si on surestime le potentiel numérique de son organisation ? Quels sont les effets ? Comment y pallier ?

#1 Comment se décline la surestimation du potentiel numérique ?

Il y a 3 périmètres à prendre en compte :

- Les effectifs ;

- Les compétences ;

- L’environnement technique.

| Qu’est-ce qu’on surestime concernant les effectifs ? | ||

| A. Le nombre de personne réellement disponibles pour travailler sur le projet

Le facteur de surestimation ? o Des problématiques de priorisation du côté des équipes qui pensent être disponibles mais n’ont pas vérifié en amont si elles l’étaient vraiment Les effets ? o Une surcharge o Des doublons, des conflits de planning |

B. La capacité de ces personnes à prendre en charge un nouveau projet

Le facteur de surestimation ? o Ne pas tenir compte d’une potentialité d’imprévu Les effets ? o Une mise en place, sans documentation, ni accompagnement o Du côté des équipes métier, une mauvaise prise en main des outils, qui génèrent une surcharge et/ou des erreurs de saisie |

C. Le nombre de personne nécessaire pour travailler sur le projet

Le facteur de surestimation ?

o Recruter ou externaliser, en cas de problématique de planning ou d’organisation, plutôt que de réévaluer les charges de travail

– OU –

o Manque de moyens et/ou de professionnel•les disponibles (pour ce sujet-là, nous n’avons pas vraiment de solutions, mais il doit quand même être pris en compte)

Les effets ?

o Des surcoûts

o Un fort turn-over

o Des retards

o Désengagement des équipes

| Qu’est-ce qu’on surestime concernant les compétences ? | |

| La maîtrise réelle des technologies qui vont être mises en place Le facteur de surestimation ? o Ne pas valider auprès des équipes techniques leur niveau de compétences, ni le temps qu’il leurs faudra pour monter en compétences o Ne pas avoir passé en revue les compétences requises pour aboutir le projet o Ne pas valider auprès des équipes métier qu’elles savent utiliser la solution qui va être mise en place, ni si elles ont besoin d’un accompagnement Les effets ? |

| Qu’est-ce qu’on surestime concernant l’environnement technique ? |

| o La compatibilité avec l’existant o La fiabilité de son système d’information o La capacité à maintenir un nouveau projet dans le temps o L’ancienneté de son environnement Le facteur de surestimation ? Les effets ? |

#2 Comment pallier ces différentes situations ?

A. Pour la surestimation des effectifs

- Avant de positionner les équipes, passer en revue les projets en cours et en retard

- Définir les plannings de manière collaborative, en tenant toujours des projets inachevés

- Valider régulièrement, auprès des équipes, que les niveaux de priorisation restent cohérents et réalisables

- Ne pas hésiter à mettre des sujets en pause ou à reporter des échéances, s’il n’y a pas d’autres alternatives

B. Pour la surestimation des compétences

- Passer en revue les compétences requises pour mettre en place un nouveau projet informatique, des équipes techniques, jusqu’aux utilisateurs finaux

- Valider la capacité de chaque partie prenante à comprendre et prendre en main les tâches qui vont leur être assignées

- Anticiper et bloquer du temps pour que les parties prenantes puissent monter en compétences, si la solution le requiert

- Anticiper et bloquer du temps pour accompagner les utilisateurs finaux

C. Pour la surestimation de l’environnement technique

- Évaluer sa dette technique

- Définir des critères de compatibilité et de sécurité

- Réaliser des mises à jour

- Réaliser des tests de manière systématique et structuré

- Réaliser des sauvegardes régulières

- Définir un plan de maintenance et des modalités de support

- Communiquer régulièrement sur l’arrivée d’une nouvelle solution et les imprévus éventuels : indisponibilité, coupure de connexion, perte de données…

Comment vulgariser les jargons informatiques en entreprise ?

Comprendre le vocabulaire IT a été pour moi, lors de ma prise de poste, un réel objectif et défi à relever. Je me suis rendu compte rapidement que ma méconnaissance de ce domaine, de ce milieu, m’empêchait d’appréhender facilement mes tâches, même les plus anodines. Entre le jargon technique utilisé par mon équipe, et le langage technique du secteur informatique en général, j’ai réalisé qu’il me fallait intégrer un nouveau vocabulaire, comme une nouvelle langue, tant pour la communication interne que pour mon travail de chargée de communication externe.

En effectuant des recherches, je me suis aperçue que la problématique d’assimilation du vocabulaire, dans l’IT, était certes connue, mais rarement traité. L’utilisation d’un même vocabulaire est pourtant nécessaire pour que les équipes travaillent ensemble. Au sein de l'agence, avec mes responsables, créer un glossaire des mots qui m’étaient inconnus, s'est avéré être la solution la plus pertinente pour y remédier.

À partir de mes recherches et de mon expérience d'intégration, je vais vous partager dans cet article, les solutions que j’ai testé et approuvé pour mieux vulgariser le jargon informatique.

#1 – Pourquoi faut-il créer un jargon technique commun ?

Il y a plusieurs situations de travail où se comprendre est indispensable pour le bon déroulement d’un projet, d’une présentation, ou d’un environnement de travail serein. Par exemple, il est probable que le service comptabilité ne comprenne certains termes du jargon IT. Ce qui peut poser un problème quand iels souhaitent remonter des problèmes techniques ou appréhender de nouveaux logiciels.

Par ailleurs, certains anglicismes, très présents dans l’informatique, peuvent être porteurs de mauvaise compréhension, surtout quand l’équivalent en français existe ou qu’il s’agit d’un mot inventé dans le cadre d’un projet.

Dès la prise de poste, une bonne compréhension du jargon de l’entreprise permet aux nouveaux salarié•es de mieux comprendre son environnement de travail, les orientations de son poste, savoir quand et comment poser des questions, mais surtout comment remonter correctement des informations.

Les effets d’une mauvaise compréhension des mots ont plusieurs effets :

- L’accumulation de retard, dû aux allers-retours générés par les incompréhensions ;

- Le désengagement des équipes, par fatigue des mots complexes ;

- Le mauvais ciblage des recrutements, par incompréhension des fiches de poste, qui peut se répercuter sur l’intégration ;

- Le développement de travail invisible, à savoir passer plus de temps à comprendre ce qu’on nous dit, plutôt qu’à réaliser ses tâches ;

- La perte de cohésion, entre les initiés et les apprenants…

Il s’agit alors d’aller au plus simple pour que tout le monde puisse se comprendre. La solution : la vulgarisation systématique des termes techniques, ou la co-création d’un jargon commun. Deux solutions sont possibles : désigner des référent•es pour traduire les termes ou mettre en place une démarche collective de vulgarisation.

#2 – Faciliter les questions

- En réunions

Pour éviter les hors sujets, les réunions peuvent être un moment propice pour valider une compréhension commune des enjeux techniques. Pour cela, le plus simple est d’accorder un temps de questions-réponses et de permettre d’échanger avec un•e référent•e, lorsqu’interviennent des termes inconnus. Cela permet d’appréhender sereinement le reste des échanges, et de ne pas prendre le risque de clôturer la réunion sur une incompréhension.

- Dans les échanges quotidiens

Lors d’une prise de poste notamment, il vaut mieux vérifier régulièrement qu’un terme technique signifie la même chose pour tout le monde.

En effet, Erwan Moyon, ingénieur informatique témoigne : « Il y a une réelle nécessité de reformuler régulièrement ce que je dis, avec du vocabulaire basique, pour que le métier puisse bien comprendre la situation et les enjeux des équipes IT. Même pour les équipes IT entre elles, on n’utilise pas forcément les mêmes mots pour les mêmes outils : la marque du logiciel, le fonctionnement, etc. Au fil des expériences, je me rends compte qu’un quiproquo sur deux, vient d’un décalage de définition. Depuis plusieurs années, j’appréhende mes missions en prenant le temps de formaliser le jargon de chacun, pour savoir quel vocabulaire utilisé avec qui. Cela favorise une compréhension plus rapide des besoins, des incidents, etc. ».

- Dans l’élaboration des consignes de travail

Lors d’une prise de poste :

Pour la recrue, il est essentiel qu’elle prenne le temps de consulter la documentation des processus, lorsqu’elle est documentée. Si ce n’est pas le cas, cela devrait être remonté aux managers, et enclencher des échanges pour bien les comprendre.

Pour l’employeur, il est important de vérifier que les consignes données ont été bien comprise : soit en pointant la documentation, soit en prenant le temps de reformuler son propre vocabulaire. Prendre ce temps à cette étape évitera d’en perdre plus tard.

Lors de la répartition des tâches :

Pour le donneur d’ordre, vulgariser les tâches restent un travail constant, pour éviter d’avoir à reprendre le travail des équipes et limiter les conflits. Pour Fen Rakotomalala, consultante informatique, il faut « systématiquement demander si les tâches sont comprises […] Dans mon cas, c’est au moment des Sprint Meeting et Sprint Review. Je crée les tâches de mon côté, puis je bloque toujours un temps pour demander à mes équipes si mes tickets sont clairs. Si oui, je garde la structure et les termes utilisés, si non je les reformule, d’après ce qu’iels comprennent.».

Lors de la définition des process :

La définition de process commun peut contribuer à la formalisation d'un jargon commun. Pour ce faire, on peut procéder de manière collaborative. Plusieurs questions se posent alors pour co-construire ces process : Qu’est-ce qui est documenté ? Qu’est-ce qui ne l’est pas ? Quelles tâches sont systématiquement incomprises ? Quel est le meilleur support de mutualisation à utiliser, en fonction de la maturité digitale de chacun ?

#3 – Créer et alimenter un glossaire commun

« Le devoir d'un développeur est de vulgariser son travail de manière à le rendre compréhensible pour tous, mais ce n'est pas toujours chose aisée. » témoigne Nicolas BRONDIN-BERNARD, ingénieur indépendant. Pour cela, quoi de plus simple et d’universel, qu’un glossaire commun ! Il s’agit de répertorier et de noter tous les mots incompris, ou considérés comme complexes, puis de les classer idéalement par thématique et ordre alphabétique.

On peut agrémenter le glossaire d’un canal de communication commun, pour remonter de nouveaux mots à définir, et pour le maintenir à jour si certains mots viennent à évoluer.

Ces définitions peuvent ensuite faire l’objet d’une communication interne régulière. Ainsi, chaque personne peut s’y tourner dès qu’un mot lui paraît obscure. Chaque personne peut aussi s’y référer, avant de remonter une information, pour valider qu’elle l'a formulé correctement. Dans le cadre d’une prise de poste, le glossaire peut également être intégré au Kit de bienvenue.

Le glossaire peut être rédigé de différentes manières :

- De manière collaborative :

- Vous pouvez organiser un atelier avec les équipes informatiques et leurs interlocuteurs, afin que chacun formalise les mots incompris, leurs définitions, leur classification et le format de diffusion du glossaire ;

- Vous pouvez mettre en place un espace d’échange permanent où les moins initiés peuvent librement demander une définition, puis les experts répondent ;

- En amont de chaque projet informatique, vous pouvez aussi rassembler les parties prenantes, pour qu’elles définissent ensemble le jargon qui sera employé au cours du projet.

- De manière unique :

Une personne peut être nommée responsable de ce glossaire. Les équipes lui remontent alors les mots à définir. Ensuite, soit elle les connait et les définie, soit elle demande au service concerné de les traduire. Ce sera à elle de les rentrer dans le document prévu comme glossaire.

En fonction de la demande, cette mise à jour peut être mensuelle ou trimestrielle. C’est à votre entreprise de définir la récurrence de cette tâche.

- Sur quelle plateforme ?

Afin que le glossaire soit utilisé, il est essentiel de le diffuser via un format qui puisse être facilement mis à jour et diffusé à l’ensemble de l’entreprise :

- Un intranet via des solutions type Sharepoint ou Notion : dans un onglet accessible à tous, prévoir une page partagée, où les mots incompris sont définis et classés par section

- Un drive commun : possibilité de créer un dossier où chaque fichier est géré par un pôle métier différent. De cette façon, chaque pôle est responsable de la vulgarisation des termes, qui posent des incompréhensions aux équipes avec lesquelles ils interagissent

- Une newsletter ponctuelle : avec un format ludique, une newsletter peut permettre d’informer sur un rythme régulier les définitions du moment, leur évolution, leur champ d’exploitation…

- Des vidéos : si vous en avez les moyens techniques et financiers, animer les définitions en vidéos, en les classant par thème, par métier, peuvent permettre de mieux schématiser un processus, une technologie, une méthode…

#4 – Pour aller plus loin.

Vous pouvez consulter notre manière de décrypter et de rendre plus accessible des mots purement techniques au grand public.

#CoolLeMot : C'est quoi un Algorithme ? Cliquer ici

#CoolLeMot : C'est quoi la Blockchain ? Cliquer ici

#CoolLeMot : C’est quoi un Malware ? Cliquer ici

Chaque secteur a un jargon qui lui est propre. Pour pouvoir travailler simplement, sans quiproquo, le mieux est d’utiliser les mêmes termes, pour les mêmes usages. Lorsque la communication est difficile, cela peut avoir plus effets sur les équipes :

- Des conflits à la suite d’une frustration liée à l’incompréhension

- La rétention d’informations ou un mauvais timing de remontée d’informations ;

- Des retards dans le déroulement d’un projet.

Pour impliquer toutes les équipes dans la vulgarisation du jargon informatique, un glossaire des termes purement techniques, régulièrement mis à jour, peut contribuer à limiter les quiproquos.

Pour cela, plusieurs solutions possibles :

- Faciliter les échanges autour des jargons informatiques ;

- Privilégier des démarches collaboratives dans la définition de process, répartition des tâches…

- Définir un glossaire commun et le diffuser sur des supports ciblés en fonction des activités qui gravitent autour des projets informatiques.

Même avec un glossaire, il est important de veiller régulièrement à ce que toutes les informations partagées, au cours d’un projet informatiques, soient comprises par tous : les équipes IT entre elles, de l’IT au Métier mais aussi du Métier à la direction.

Si elle n'a pas de bagage informatique, ce n’est pas forcément à l’équipe de communication de se charger de reformuler les termes techniques. L’équipe de communication a un rôle de centralisation, mais aura toujours besoin des équipes IT pour le contenu, des équipes métier pour évaluer leur pertinence. D’où l’importance que tout le monde soit bien formé et sensibilisé aux jargons informatiques.

À quoi sert un audit informatique ?

Un audit informatique est un outil de contrôle dont l’objectif est d’évaluer la situation et le niveau de conformité de l’entreprise dans le cadre d’un projet informatique, et ce, afin de valider les dispositifs et l’organisation associés. Il ne fournit pas de solutions.

Il est très souvent réalisé dans la contrainte (demande d’un client, obligation réglementaire…), rarement sur la base d’une initiative interne. Mais concrètement, un audit informatique c’est quoi ? Comment ça s’organise ? Quels sont ses avantages ?

Afin de comprendre les opportunités liées à la réalisation d’un audit, il faut comprendre ses objectifs, son articulation et la manière de l’utiliser.

#1 - Qu’est-ce qu’un audit informatique ?

Un audit est une démarche d’évaluation qui se base sur une liste de contrôle à réaliser sur un sujet donné. Cette liste permet de réaliser un état des lieux de la conformité d’une entreprise.

Il est rarement obligatoire, sauf dans le cadre de certaines réglementations, notamment dans le cadre d’audit de sécurité informatique.

La liste de contrôles se veut objective et exhaustive. Elle n’a pas pour objectif de fournir un jugement sur l’activité d’une entreprise. Elle doit uniquement contrôler si un point est respecté et/ou réalisé.

On peut en dégager au mieux une feuille de route mais sans s’y engager. La recherche de solutions est à la charge de l’entreprise auditée.

Il existe autant d’audit qu’il existe d’activités informatiques au sein d’une entreprise : sécurité, gestion des info gérants, continuité d’activité, développement de codes…

On peut catégoriser l’ensemble de ces audits en deux familles :

- Audit global dont l’objectif est d’évaluer une activité de l’entreprise avec l’informatique qui lui est associée

- Audit spécifique dont l’objectif est d’évaluer une activité informatique particulière au sein d’une entité de l’entreprise

En informatique, il existe principalement 4 types d’audit :

- Organisationnel : Contrôler le pilotage de l’activité informatique comprenant les rôles et responsabilités, les processus et procédures, les dispositifs de contrôles internes, les tableaux de bords…

- Sécurité : Contrôler l’application de la sécurité au système d’information comprenant le management, les procédures, les projets, le code et les vulnérabilités...

- Application / Logiciel : Contrôler les méthodes de développement de logiciels et d’applications comprenant la maintenance, le Security by Design, le pilotage projet, le patching…

- Exploitation : Contrôler le fonctionnement opérationnel des services informatiques, comprenant les outils de surveillance du système d’information en temps réel, les serveurs, les applications, les sites internet, le support…

Un audit a ainsi toujours un objectif précis, auquel on associe un type d’audit. Pour choisir le type d’audit à réaliser, il faut également comprendre comment il s’organise.

#2 - Comment s’articule un audit ?

Un audit se déroule sous plusieurs contextes :

- À la demande d’un client

- À la demande d’une entité légale

- Pour valider un prestataire ou un fournisseur

Avant de le réaliser, plusieurs actions préparatoires sont nécessaires :

- Identifier le sujet à contrôler

- Communiquer la volonté de contrôler ce sujet auprès des équipes concernées

- Sélectionner un auditeur externe ou une entité interne

Pour maintenir l’objectivité de l’exercice, il est nécessaire de se faire accompagner par une entreprise tierce lorsque le sujet à contrôler est nouveau.

Ensuite, l’audit s’articule de la manière suivante :

- Phase de cadrage

- Valider le périmètre à contrôler

- Valider les équipes cibles et leurs disponibilités pour répondre à l’audit

- Valider les questions et thèmes de l’audit à aborder

- Planifier les différentes étapes de l’audit

- Phase de réalisation

- Bloquer du temps auprès des équipes auditées

- Mener l’audit

- Communiquer autour de l’avancement de l’audit

- Phase de restitution

- Synthétiser et présenter les résultats de l’audit

- Proposer des recommandations et des axes d’amélioration (si demandés)

Un audit est donc un ensemble de phases à réaliser de manière systématique et répétitive. C’est cette répétitivité qui permet de donner un cadre, un moyen de contrôle et de comparaison entre deux audits sans donner de jugement, afin de déterminer les opportunités d’amélioration.

#3 - Quels sont les avantages d’un audit ?

Un audit permet à une entreprise de réaliser des contrôles de son activité informatique, à un instant T. Il permet également de contrôler un tiers et de s’assurer que ce dernier est conforme aux exigences de l’entreprise.

Un audit identifie objectivement le niveau de conformité d’une entreprise, pour l’aider à identifier ses manques et à définir une feuille de route. Il n’a pas vocation à fournir les solutions.

Même si un audit requiert la mobilisation d’une partie des équipes de l’entreprise, son aboutissement offre une vue simple et efficace des actions à mettre en place pour remettre l’entreprise en conformité avec les normes informatiques.

Dans l’idéal, il est pertinent de réaliser un audit quand :

- L’activité de l’entreprise est dépendante d’un seul outil ;

- L’entreprise devient publiquement connue ;

- L’entreprise rentre dans un programme de fusion-acquisition ;

- L’entreprise est phase de croissance ;

- L’entreprise souhaite être certifiée.